초거대 AI모델 학습의 효율성을 높이고 GPU 활용도를 극대화할 수 있는 기술이 개발됐다.

KAIST 연구팀은 13일 삼성전자 삼성종합기술원과 공동연구를 통해 대규모 분산 시스템에서 대형 언어 모델 학습시간을 예측·최적화할 수 있는 시뮬레이션 프레임워크 'vTrain'을 개발했다고 밝혔다.

대형 언어 모델 학습에는 수만개의 GPU가 필요하며 모델 학습 비용은 수천억원에 이를 정도로 막대하다.

특히 최적의 분산 학습 전략을 찾는 것이 필수적이지만 기존에는 경험적으로 검증된 일부 전략만 사용돼 GPU 활용이 비효율적이고 비용이 증가하는 문제가 있었다.

KAIST 연구팀이 개발한 vTrain은 다양한 분산 병렬화 전략을 시뮬레이션해 최적의 학습 방식을 탐색할 수 있도록 돕는다.

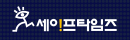

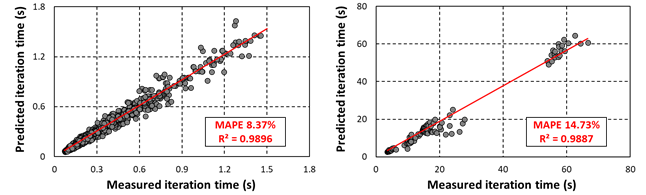

실제 다중 GPU 환경에서 학습 시간을 예측한 결과 단일 노드에서는 평균 절대 오차 8.37%, 다중 노드에서는 14.73%의 정확도를 기록하며 신뢰성을 입증했다.

연구팀은 vTrain 프레임워크와 1500개 이상의 실제 학습시간 측정 데이터를 오픈소스로 공개해 AI 연구자와 기업들이 자유롭게 활용할 수 있도록 했다.

유민수 전기·전자공학부 교수는 "vTrain은 프로파일링 기반 시뮬레이션 기법을 활용해 기존 방식보다 GPU 사용률을 높이고 학습 비용을 절감할 수 있도록 오픈소스를 공개했다"며 "기업들은 초거대 AI모델 학습비용을 효율적으로 관리할 수 있을 것"이라고 말했다.

손예림 기자

yelims930@safetimes.co.kr